Trend Olan Konular

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Shanu Mathew

İklim, Yatırım, NBA ve Rap. SVP, Portföy Yöneticisi - Sürdürülebilir Yatırım. Önceki olarak: ESG Başkanı, Yüksek Lisans Kredisi, Startup (acq.) IB. Kendi Görüşleri. RT'ler ≠ onay verir.

Bence bu kışkırtıcı bir yaklaşım ve iyi bir düşünce ama mantığı biraz üzerinde çalışmak istedim.

Bugün çoğu yapay zeka aracı bulutta çalışıyor. Her modelden bir şeyi yazmasını, özetlemesini, çevirmesini veya analiz etmesini istediğinizde, bu talep bir veri merkezindeki GPU'ya çarpıyor. Daha fazla kullanıcı, →daha fazla sorgu → daha fazla GPU → daha fazla veri merkezi → daha fazla güç hattı, trafo, trafo → daha fazla üretim vb. Bu, mevcut yapay zeka donanımı + veri merkezi sermaye patlamasının temel fınan çarkıdır.

Cihaz üzerindeki faydalı çıkarım, bu doğrusal zinciri bozar.

Eğer çok milyar parametreli bir model, telefonunuzunuzda, dizüstü bilgisayarınızda, arabanızda veya kulaklığınızdaki sinir çipinde çalışacak kadar verimliyse, günlük görevlerin büyük bir kısmı cihazdan asla ayrılmak zorunda kalmaz. Basit ama yüksek hacimli istekleri düşünün: otomatik tamamlama, e-posta taslağı, sesli transkripsiyon, özetleme, basit görüntü tanıma. Bunlar, muhtemelen kullanıma hakim olacak yüksek hacimli, düşük karmaşıklıktaki genel sorgular.

Hızlıca neyin kayabileceğine dair hissetme: Basit varsayımlar - istediğiniz gibi esnetin.

-1B kullanıcılar günde 50 sorgu × × ~$0.002/sorgu x 365 gün = ~$35B/yıl bulut çıkarımı maliyeti.

-Eğer bunun %30'u cihazda hareket ederse, bu ~$11B+ yıllık bulut talebi demektir ama hiç gerçekleşmez.

-Cihaz gönderildiğinde yerel sorgu başına marjinal maliyet fiilen ~$0'dır.

Normal uyarılar: donanım oraya doğru ilerliyor ama yine de bellek, bant genişliği vb. ölçeklendirmek gerekiyor. Ancak, bir telefonun sinir çipinde çalışan 3–7B parametre modeli (bugün yaklaşık 10–45 "TOPS", 2027'ye kadar 60+ öngörülüyor) bu yüksek hacimli, düşük karmaşıklıktaki görevleri yerel olarak halledebilir. Her istek için sınır ölçeği modellere ihtiyacınız yok.

Bulut hâlâ çok net olmak gerekir. Sınır modelleri eğitimi, uzun bağlamlı akıl yürütme, büyük kurumsal iş yükleri, çoklu ajan koordinasyonu – bunların hepsi büyük, merkezi veri merkezleri için çok daha uygun. Önemli değişim, mantık zincirinin artık "her yeni kullanıcı = daha fazla GPU ve daha fazla gigawatt veri merkezi kapasitesi eklemeliyim" olmamasıdır. Burada bilinmeyen bir şey ise Jevon'un paradoks argümanı ve bunun daha fazla yapay zeka kullanımını sürüp sürmediği, kullanıcıları daha karmaşık istemler aramaya sürükleyip bulamadığı ve bunun bir kısmını dengelediği

Aashay'ın belirttiği gibi, sermaye patlaması tamamen 'kırılmıyor', ancak mevcut yoğunluk oranı muhtemelen değiştiriliyor. Günümüz ölçeğinde buluttan cihaza çıkarım iş yüklerinin %5–30'unu bile taşımak anlamlı olabilir. Zor sorunlar bulutta merkezi kalır. Ama "günlük yapay zeka" zaten sahip olduğunuz donanımın bir özelliği haline gelir, sorgu tarafından kiralanan ölçülü bir yardımcı programın yerine.

Aashay Sanghvi4 Ara 12:33

Cihaz içi çıkarım, yapay zeka sermaye işlemlerini bozdu

11,5K

Bence Dwarkesh bununla yemek yaptı:

-RLVR paradoksu: Laboratuvarların milyarlarca dolar harcaması, belirli becerilere özel beceriler için harcıyor ve bu temel bir gerilimi ortaya koyuyor: insan benzeri öğrenenlere yakınsak, tüm bu ön eğitim anlamsız hale gelir çünkü onlar iş başında öğrenirler.

-İnsan emeğinin gerçek değeri: Her mikro-görev için özel eğitim hatlarına ihtiyacımız yok; Mevcut yapay zeka bunu yapıyor.

-Difüzyon gecikmesi = başa çıkma: Modeller insan eşdeğeri olsaydı, çalışanlardan daha hızlı entegre olurlar [Bunu tartışabilir - veri kaynağı, iş güvenilirliğine güven, ikame korkuları vb. yapay zeka dağıtımını makul bir şekilde durdurabilir; ama yine de hepimiz bunun daha iyi bir seçenek olduğuna inanırdık ve bu henüz doğru değil, bu yüzden bence bu doğru).

-Hedef noktası kaydırma oldu: AGI darboğazlarını (örneğin akıl yürütme) çözdük ama henüz bilgi çalışmalarının %95'ini otomatikleştiremedik. Zeka, daha önce fark ettiğimizden ve tanımladığımızdan daha fazlasıdır ve bunu kabul etmek normal.

-Sürekli Öğrenme Darboğazı: Gelecekteki yapay zeka patlayıcılığı, sürekli öğrenmeyi çözmeye bağlıdır - ajanlar konuşlandırılır, deneyimden öğrenilir, bilgiyi "kovan zihnine" birleştirir. Bundan çok uzak ama oraya ulaşabiliriz!

Dwarkesh Patel3 Ara 05:56

Yeni gönderi: Yapay zeka ilerlemesi üzerine düşüncelerim (Aralık 2025)

1. Neyi ölçeklendiriyoruz?

48,06K

"Doyumsuz"

"Amansız"

"Neredeyse tamamen tükenmiş"

Ben Bajarin4 Ara 23:50

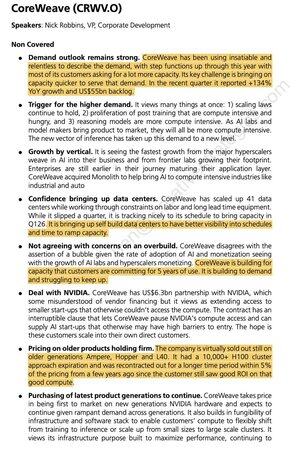

UBS Tech konferansındaki $CRWV oturumun tam özeti. Burada birçok içgörü ve biraz nüans var, ama 2026 gelir açısından sağlıklı bir @CoreWeave geçireceğine dair bir sezgim var.

5,17K

En İyiler

Sıralama

Takip Listesi