Popularne tematy

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

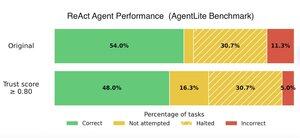

Dzisiejsze architektury agentów AI (ReAct, Plan-then-Act itd.) generują zbyt wiele błędnych odpowiedzi.

Nasz nowy benchmark to potwierdza, oceniając 5 popularnych architektur agentów w kontekście wieloetapowego odpowiadania na pytania.

Następnie dodaliśmy ocenę zaufania w czasie rzeczywistym do każdej z nich, co zmniejszyło liczbę błędnych odpowiedzi we wszystkich typach agentów: z Act o 56%, z ReAct (Zero-shot) o 56%, z ReAct (Few-shot) o 16%, z PlanAct o 25%, a z PlanReAct o 10%.

Jeśli nie możesz tolerować błędów AI, ocena zaufania działa dla każdego agenta AI i to tylko kilka linijek kodu.

Sprawdź pełny benchmark tutaj:

5,52K

Najlepsze

Ranking

Ulubione