热门话题

#

Bonk 生态迷因币展现强韧势头

#

有消息称 Pump.fun 计划 40 亿估值发币,引发市场猜测

#

Solana 新代币发射平台 Boop.Fun 风头正劲

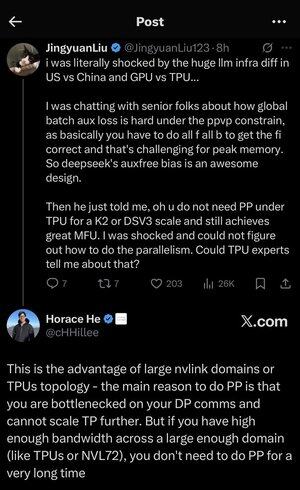

我在这里的所有缩略语和行话中有点迷失,所以我让Claude不使用任何缩略语来解释,现在一切都变得非常清晰(简而言之;带宽 ⟹ 简单性):

这是关于大规模训练大型语言模型的一个引人入胜的技术讨论。

核心对话

Jingyuan Liu 对发现使用TPU(张量处理单元 - 谷歌的专用AI芯片)与GPU(图形处理单元 - 通常是NVIDIA的芯片)时不需要某些复杂的优化技术感到惊讶。

关键技术概念解释:

硬件类型:

• GPU(图形处理单元):最初设计用于图形,现在广泛用于AI。NVIDIA主导了这个市场。

• TPU(张量处理单元):谷歌专门为机器学习设计的定制芯片。

并行策略:

在训练大型AI模型时,您需要将工作分配到多个芯片上。有几种方法可以做到这一点:

1)数据并行(DP):每个芯片处理不同批次的数据,使用相同的模型副本

2)张量并行(TP):模型的数学运算分布在多个芯片上

3)流水线并行(PP):模型的不同层放置在不同的芯片上,形成一个流水线

正在讨论的技术挑战:

辅助损失问题:在训练非常大的模型时,您通常会在中间层添加“辅助损失”(额外的训练目标),以帮助梯度更好地在网络中流动。在PPVP(具有可变分区的流水线并行)约束下,这变得复杂,因为:

...

热门

排行

收藏