Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

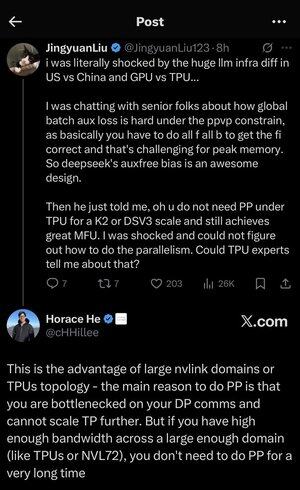

Eksyin hieman kaikkiin lyhenteisiin ja jargoniin, joten pyysin Claudea selittämään sen ilman lyhenteitä, ja nyt kaikki on täysin järkevää (tldr; kaistanleveys ⟹ yksinkertaisuus):

Tämä on kiehtova tekninen keskustelu suurten kielimallien kouluttamisesta mittakaavassa.

Keskustelun ydin

Jingyuan Liu ilmaisee yllätyksensä huomatessaan, että et tarvitse tiettyjä monimutkaisia optimointitekniikoita, kun käytät TPU:ita (Tensor Processing Units - Googlen erikoistuneet AI-sirut) verrattuna GPU:ihin (Graphics Processing Units - tyypillisesti NVIDIAn siruihin).

Keskeiset tekniset käsitteet selitettynä:

Laitteistotyypit:

•GPU (Graphics Processing Unit): Alun perin suunniteltu grafiikkaa varten, nyt käytetään paljon tekoälyssä. NVIDIA hallitsee näitä markkinoita.

•TPU (Tensor Processing Unit): Googlen räätälöidyt sirut erityisesti koneoppimiseen.

Rinnakkaisuusstrategiat:

Kun harjoitat massiivisia tekoälymalleja, sinun on jaettava työ useille siruille. On olemassa useita tapoja tehdä tämä:

1) Tietojen rinnakkaisuus (DP): Jokainen siru käsittelee eri tietoeriä samalla mallikopiolla

2) Tensorin rinnakkaisuus (TP): Mallin matemaattiset operaatiot on jaettu sirujen kesken

3) Putkilinjan rinnakkaisuus (PP): Mallin eri kerrokset sijoitetaan eri siruille, mikä luo putkilinjan

Tekninen haaste, josta keskustellaan:

Apuhäviöongelma: Kun harjoitat erittäin suuria malleja, lisäät usein "apuhäviöitä" (ylimääräisiä harjoitustavoitteita) välikerroksiin, jotta gradientit virtaavat paremmin verkon läpi. PPVP (Pipeline Parallelism with Variable Partitioning) -rajoituksissa tästä tulee monimutkaista, koska:

...

Johtavat

Rankkaus

Suosikit