Populární témata

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

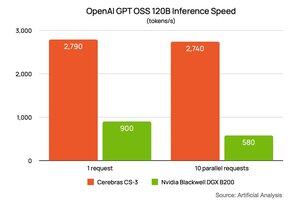

Začátkem tohoto týdne @NVIDIA se podělil o svůj výkon na modelu gpt-oss-120B od @OpenAI běžícím na DGX B200 (8 dvou čipů Blackwell). Požádali @ArtificialAnlys analýzu, aby pro ně vytvořila speciální nastavení. Ukazovaly výkon 900 tokenů za sekundu pro jednoho uživatele a klesly na 580 tokenů za sekundu pro 10 uživatelů. Vložil jsem jejich odkaz do komentářů níže.

Požádali jsme společnost Artificial Analysis, aby pro nás spustila stejné nastavení. Výsledkem je ~2700 token/s pro 1 a totéž pro 10 uživatelů. Inference @CerebrasSystems je nejen nejrychlejší, ale také udržujeme výkon, i když můžete škálovat své úlohy. Cerebras Inference je dnes v plné produkci a poskytuje miliardy GPT 120B token týdně na @OpenRouterAI, @huggingface a Cerebras Cloud.

80,07K

Top

Hodnocení

Oblíbené