Trendaavat aiheet

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

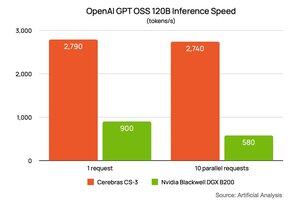

Aiemmin tällä viikolla @NVIDIA kertoi suorituskyvystään @OpenAI:n gpt-oss-120B-mallissa, joka toimii DGX B200:lla (8 kahden muotin Blackwell-sirua). He pyysivät @ArtificialAnlys analyysiä tekemään heille erityisen asetelman. Niiden suorituskyky oli 900 merkkiä sekunnissa yhdelle käyttäjälle ja putosi 580 tokeniin sekunnissa 10 käyttäjällä. Olen liittänyt heidän linkkinsä alla oleviin kommentteihin.

Pyysimme Artificial Analysisia suorittamaan saman asennuksen puolestamme. Tulos on ~2700 token/s 1:lle ja sama 10 käyttäjälle. Sen lisäksi, että @CerebrasSystems Inference on nopein, ylläpidämme suorituskykyä, kun lisäät työmäärääsi. Cerebras Inference on tänään täydessä tuotannossa, ja se palvelee miljardeja GPT 120B -tokeneita viikossa @OpenRouterAI, @huggingface ja Cerebras Cloudissa.

80,07K

Johtavat

Rankkaus

Suosikit