Temas en tendencia

#

Bonk Eco continues to show strength amid $USELESS rally

#

Pump.fun to raise $1B token sale, traders speculating on airdrop

#

Boop.Fun leading the way with a new launchpad on Solana.

Liron Shapira

Multitud de debates de Doom: desacuerdos que deben resolverse antes de que se acabe el mundo.

Puede *pensar* que esto prueba sin lugar a dudas la existencia de una alta inteligencia general, pero en realidad solo muestra que es posible aprender una combinación específica de habilidades de la cultura que lo rodea. Los datos de entrenamiento correctos le permiten hacer coincidir el patrón del siguiente paso de construcción de salas limpias.

Matthew Hartensveld, PhDhace 15 horas

Cobertizo de sala limpia de clase 100 que construí para investigación y desarrollo de semiconductores :)

920

📢 EXCLUSIVA DE NEW DOOM DEBATES: ¡Una entrevista con Rob Miles (@robertskmiles), el educador de seguridad de IA más popular en YouTube!

Sorprendentemente, Rob comenzó en 2011, mucho antes de que ChatGPT atrajera la atención general al campo. Hablamos de:

👉 Por qué su P(Doom) se encuentra entre el 10 y el 90%, dependiendo de cómo responda la humanidad al desafío

👉 Por qué incluso los sistemas de IA perfectamente alineados podrían no transmitir sus valores a los sistemas sucesores: un punto ciego masivo en el trabajo de seguridad actual

👉 El problema del "estado de ánimo perdido": por qué la gente discute la posible extinción humana con la urgencia emocional de una conferencia académica en lugar de tratarla como la emergencia que es

👉 Su escenario principal de fatalidad a través de la superación personal recursiva, y por qué hay un enorme margen por encima de la inteligencia humana

👉 Si los humanos son la "especie menos inteligente capaz de civilización tecnológica", y qué significa eso para lo que podrían lograr los sistemas más inteligentes

👉 Nuestro desacuerdo clave: Rob cree que las personas de seguridad deberían trabajar dentro de las empresas de IA para la reducción de daños, mientras que yo sostengo que esto permite el "lavado de manejabilidad" que legitima a las empresas fundamentalmente imprudentes

👉 Estrategia de comunicación: Rob se pregunta si a su enfoque británico mesurado le falta algo crucial, y tal vez alguien necesita estar "corriendo gritando" para transmitir la urgencia adecuada.

Rob ha pasado más de una década tratando de despertar a la gente al desafío más importante de la humanidad. Nuestra conversación revela la tensión entre el análisis razonado y la emergencia existencial. ¡Muy recomendable!

12.67K

¿Cómo fue tan precisa la idiocracia?

Elon Musk21 ago, 20:53

Ani está bien 👌

6.22K

Liron Shapira reposteó

Hay algo curioso en el que la educación económica paradójicamente hace que la gente sea MÁS TONTA al pensar en la IA del futuro. Los libros de texto de economía enseñan conceptos y marcos que son excelentes para la mayoría de las cosas, pero contraproducentes para pensar en AGI. Aquí hay 4 ejemplos. Poste largo:

La primera pieza de la anti-pedagogía económica se esconde en las palabras "trabajo" y "capital". Estas palabras combinan una diferencia superficial (humano de carne y hueso versus no) con un conjunto de suposiciones e intuiciones tácitas, que serán rotas por la Inteligencia General Artificial (AGI).

Por "AGI" me refiero aquí a "un conjunto de chips, algoritmos, electricidad y/o robots teleoperados que pueden hacer de forma autónoma el tipo de cosas que los adultos humanos ambiciosos pueden hacer: fundar y dirigir nuevas empresas, investigación y desarrollo, aprender nuevas habilidades, usar robots teleoperados arbitrarios después de muy poca práctica, etc."

Sí, lo sé, ¡esto aún no existe! (A pesar de la exageración de lo contrario). Intente pedirle a un LLM que escriba de forma autónoma un plan de negocios, fundar una empresa y luego dirigirla y hacerla crecer durante años como CEO. ¡Lol! ¡Se estrellará y arderá! Pero esa es una limitación de los LLM de hoy, no de "toda la IA para siempre". La IA que podría lograr esa tarea, y mucho más, es obviamente posible: los cerebros, los cuerpos humanos y las sociedades no están impulsados por una hechicería mágica que esté siempre fuera del alcance de la ciencia. Por mi parte, espero una IA así en mi vida, para bien o para mal. (Probablemente "peor", ver más abajo).

Ahora bien, ¿es este tipo de AGI "trabajo" o "capital"? Bueno, no es un humano de carne y hueso. Pero se parece más al "trabajo" que al "capital" en muchos otros aspectos:

• ¿El capital no puede simplemente levantarse y hacer las cosas por sí mismo? AGI puede.

• ¿Las nuevas tecnologías tardan mucho tiempo en integrarse en la economía? Bueno, pregúntese: ¿cómo logran los humanos inmigrantes altamente calificados, experimentados y emprendedores integrarse en la economía de inmediato? Una vez que haya respondido esa pregunta, tenga en cuenta que AGI también podrá hacer esas cosas.

• ¿El capital se queda inactivo si no hay humanos dispuestos y capaces de usarlo? Bueno, esos humanos inmigrantes no se quedan de brazos cruzados. Y tampoco lo hará AGI.

• ¿El capital no puede abogar por los derechos políticos o lanzar golpes de estado? Pozo...

De todos modos, la gente ve películas de robots de ciencia ficción, ¡y entienden esto! Luego toman cursos de economía, y eso los hace más tontos.

(Sí, lo sé, #NotAllEconomists etc.)

La segunda pieza de la antipedagogía económica es inculcar una suposición predeterminada de que es posible que un mercado se equilibre. Pero el mercado de AGI no puede: AGI combina una propiedad de los mercados laborales con una propiedad de los mercados de productos, donde esas propiedades son mutuamente excluyentes. Esas propiedades son:

• (A) "SIN GRUMOS DE MANO DE OBRA": Si la población humana aumenta, los salarios caen a muy corto plazo, porque la curva de demanda de mano de obra se inclina hacia abajo. Pero a largo plazo, las personas encuentran nuevas cosas productivas que hacer: la curva de demanda se mueve hacia la derecha. En todo caso, ¡el valor del trabajo sube, no baja, con la población! Por ejemplo, las ciudades densas son motores de crecimiento.

• (B) "CURVAS DE EXPERIENCIA": Si la demanda de un producto aumenta, hay un aumento de precios a muy corto plazo, porque la curva de oferta se inclina hacia arriba. Pero a largo plazo, la gente aumenta la fabricación: la curva de oferta se mueve hacia la derecha. En todo caso, el precio baja, no sube, con la demanda, gracias a las economías de escala y la investigación y el desarrollo.

PRUEBA: Teniendo en cuenta (A) y (B), ¿cuál es el precio de equilibrio de este paquete AGI (chips, algoritmos, electricidad, robots teleoperados, etc.)?

… ¡Pregunta capciosa! No hay equilibrio. Nuestros dos principios, (A) "sin grumos de trabajo" y (B) "curvas de experiencia", hacen imposible el equilibrio:

• Si el precio es bajo, (A) dice que la curva de demanda corre hacia la derecha: no hay un montón de mano de obra, por lo tanto, se pueden obtener ganancias masivas de los AGI empresariales calificados que encuentran nuevas cosas productivas que hacer.

• Si el precio es alto, (B) dice que la curva de oferta corre hacia la derecha: se pueden obtener ganancias masivas al aumentar la fabricación de AGI.

• Si el precio está en el medio, ¡entonces la curva de demanda y la curva de oferta están corriendo hacia la derecha!

Esto no es ni capital ni trabajo tal como lo conocemos. En lugar de que el mercado de AGI se equilibre, forma un ciclo de retroalimentación positiva / máquina de movimiento perpetuo que explota exponencialmente.

¿Suena absurdo? Hay un precedente: ¡humanos! ¡El mundo humano, en su conjunto, ya es un circuito de retroalimentación positiva / máquina de movimiento perpetuo de este tipo! Los humanos pasaron de unos pocos miles de homínidos a 8 mil millones de personas que dirigían una economía de 80 billones de dólares.

¿Cómo? No es literalmente una máquina de movimiento perpetuo. Más bien, es un motor que se nutre del pozo de "oportunidades económicas aún no explotadas". Pero recuerde "No Lump of Labour": el pozo de oportunidades económicas aún no explotadas es ~infinitamente profundo. No nos hemos quedado sin posibles empresas para fundar. Nadie ha hecho un enjambre de Dyson todavía.

Hay un número limitado de humanos para fundar empresas y explotar nuevas oportunidades. Pero el ciclo de retroalimentación positiva de AGI no tiene ese límite. El tiempo de duplicación puede ser corto:

Imagine una fábrica autónoma que puede construir una fábrica autónoma idéntica, que luego construye dos más, etc., utilizando solo materiales de entrada ampliamente disponibles y luz solar. Los libros de texto de economía no hablan de eso. ¡Pero los libros de texto de biología sí! Una cianobacteria es una fábrica de este tipo y puede duplicarse en un día (tasa 😛 de crecimiento anualizada del ≈ por ciento de googol).

De todos modos, no sabemos qué tan explosivo será el ciclo de retroalimentación positiva de AGI construyendo AGI, pero espero que esté a años luz de cualquier cosa en la historia económica.

La tercera pieza de la antipedagogía económica es su promoción del crecimiento del PIB como indicador del progreso y el cambio. Por el contrario, es posible que el mundo se transforme en una tierra salvaje de ciencia ficción más allá de todo reconocimiento o comprensión cada mes, mes tras mes, sin que el "crecimiento del PIB" sea realmente tan alto. El PIB es una métrica divertida y especialmente pobre para describir el impacto de las revoluciones tecnológicas transformadoras. (Por ejemplo, si alguna tecnología nueva es barata y, mientras tanto, otros sectores de la economía siguen siendo caros debido a las restricciones regulatorias, entonces la nueva tecnología podría no afectar mucho al PIB, sin importar cuánto cambie el mundo). Quiero decir, claro que podemos discutir sobre el PIB, pero no debemos tratarlo como una batalla de poder sobre si AGI será o no un gran problema.

Por último, y lo más importante, LA CUARTA PIEZA de la antipedagogía económica es el enfoque en "intercambios mutuamente beneficiosos" en lugar de "matar gente y tomar sus cosas". Econ 101 demuestra que el comercio es egoístamente mejor que el aislamiento. Pero a veces "matar gente y tomar sus cosas" es egoístamente lo mejor de todo.

Cuando hablamos de AGI, estamos hablando de crear una nueva especie inteligente en la Tierra, una que eventualmente será más rápida, más inteligente, mejor coordinada y más numerosa que los humanos.

La gente normal, la gente que ha visto películas de ciencia ficción sobre robots y extraterrestres, la gente que ha aprendido la historia del colonialismo y la esclavitud, inmediatamente hará muchas preguntas razonables aquí. "¿Cuáles serán sus motivos?" "¿Quién tendrá el poder duro?" "Si parecen amigables y cooperativos desde el principio, ¿podrían apuñalarnos por la espalda cuando se vuelvan más poderosos?"

¡Estas son excelentes preguntas! ¡Definitivamente deberíamos hacer estas preguntas! (FWIW, esta es mi área de especialización, y soy muy pesimista).

… Y luego esa gente normal toma clases de economía y termina siendo más estúpida. Dejan de hacer esas preguntas. En cambio, "aprenden" que AGI es "capital", algo así como una máquina de moldeo por inyección. Las máquinas de moldeo por inyección no acabarían con los humanos y gobernarían el mundo por sí mismas. Así que estamos bien. Lol.

39.15K

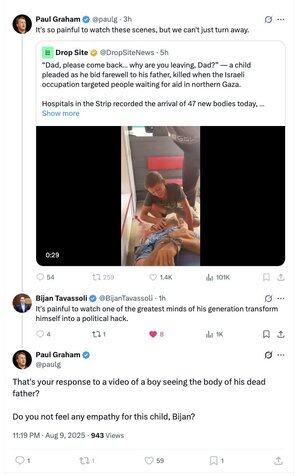

.@paulg debe ser fanático de la Sra. Rachel.

Ambos usan el mismo truco evasivo: tratar los dos nodos (acción israelí)→ (víctimas civiles) como todo el contexto causal sobre el cual opinar.

P: ¿Se debe permitir que funcionen los escudos humanos?

R: La vida de todos los no combatientes vale lo mismo 🧘

Liron Shapira10 ago, 16:33

Hola @paulg, tu participación en este discurso sigue siendo frustrantemente improductiva.

"¿No sientes empatía???" es lo mismo que ambas partes están diciendo. Cada israelí también fue víctima de crímenes de guerra hoy, con nuestros escuálidos rehenes aún siendo privados de comida otro día más. ¿Tú *no* sientes ninguna empatía??? Ok, entonces, ambos sentimos empatía.

La empatía, contrariamente a lo que pareces estar insinuando en tus tweets continuos, no implica que un plan particular para que Israel defienda su soberanía contra el enemigo aún decidido sea mejor que otro. No hay una simple opción de "solo deja de causar muertes". Hamas hizo demandas severas para un alto el fuego.

Por favor, solo dinos cuál es tu objetivo. Sabes que "prevenir muertes" no es una respuesta aclaratoria sobre tu posición. Uno tiene que ampliar su contexto y lidiar con la red causal más grande para dar una respuesta.

¿Quieres que el control judío soberano sobre Israel termine? ¿Preferirías dejar que los islamistas "regresen" libremente a él?

No estoy poniendo palabras en tu boca, ni te estoy llamando antisemita. Solo solicito que, por el bien de un discurso de calidad, nos des más contexto sobre tus resultados deseados en lugar de solo jugar una parte de una carta de empatía simétrica.

3.84K

Populares

Ranking

Favoritas

Onchain en tendencia

Tendencia en X

Principales fondos recientes

Más destacadas